В консоле вебмастера google есть пункт меню "Основные интернет-показатели", в нем показываются ошибки и предупреждения разные, о них вы можете прочитать в помощи.

Последнее время google меняет правила очень кардинально и robots.txt уже не защитит сайт от дублей при некоторых условиях. Вот ссылочка о конкретно описываемой ситуации когда страницы будут проиндексированы, несмотря на запрет в robots.txt.

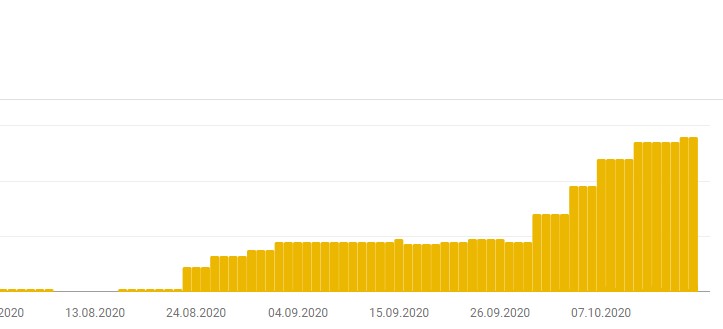

Если вы посмотрите в этот пункт меню консоли(открыв соответствующий отчет), вы можете увидеть такую картинку, конечно если ваш сайт уже продвинулся немного.

Название предупреждения: Проиндексировано, несмотря на блокировку в файле robots.txt

Растут такие страницы просто с дикой скоростью, в моем случаи большая часть ссылок имеет параметр ?action-rcl=login. Есть конечно и другие, но на этом параметре покажу пример, как избавится от таких дублей, так как и канонический урл в данном случаи не работает(маны гугла).

В файл функций вашей темы сайта надо добавить:

// ноиндекс с параметром

function yw_noindex_follow() {

$url = $_SERVER['REQUEST_URI'];

if (strpos($url,'?action-rcl=login') !== false) {

echo '<meta name="robots" content="noindex, follow" />' . "\n";

}

}

add_action( 'wp_head', 'yw_noindex_follow', 1);

Возможны вариации конечно, можно вообще оставить только "?", но это уже по необходимости, как и добавить другие варианты ссылок от дополнений или плагинов.

В итоге, исходя из рекомендаций google, мы закрываем все дубли. После проделанной операции с добавлением кода, обязательно проверить, что все гладко и запрет появляется только на нужных страницах. Далее нажать на кнопку перепроверки в консоле и ошибки исчезнут со временем, придет оповещение на почту.

Таким образом индекс сайта будет чистым и не только для гугла, но и для яндекса. Единственная защита на сегодняшний день от дублей: <meta name="robots" content="noindex, follow" />

Спасибо, Игорь, полезная информация.

Думаю, если на сайте используется ЧПУ, то можно вообще отсекать все get-параметры

add_action( 'wp_head', function() { if (isset($_GET) && $_GET) { echo '' . "\n"; } }, 1);О да, классное решение, Андрей! Сегодня внедрю у себя. Иначе просто ужас теперь, ни роботс, ни каноничесике не указ поисковикам. У них теперь свой ИИ и он решает, что в индекс запихивать.

с ИИ бороться бесполезно, однажды он станет еще умнее, начнет игнорировать метатеги и захватит мир, поместив его в индекс)

Пора начинать задумываться, какого цвета выбрать таблетку)

...или принять горстью все таблетки сразу.

Как показала практика, бороться с гуглом по этому вопросу невероятно сложно.

Ему вообще плевать на все директивы. Сейчас отдаю 404 и то, он умудряется лепить дубли. Но с 404 дело пошло живее.

наверно потому что они сами нейросеть бота перестали контролировать))

"Ой, он и меня посчитал" - как в советском мультике

Так и есть, за последнее время столько всего на вводили, что контроль утерян. А может мы давно в матрице))

Здравствуйте. А что, если на сайте присутствуют файлы для скачивания, и урл к ним имеет такой вид:

site.com/?get=filename

И при нажатии на ссылку сразу происходит скачивание файла, а не переход на другую страницу, которую можно закрыть noindex-ом

В роботсе все такие урлы закрыты, и поэтому приходит как раз такая ошибка: Проиндексировано, несмотря на блокировку в файле robots.txt

Да и на сами ссылки нацепил nofollow - и это не помогает.

Что можно сделать с такими ссылками?

Самый простой вариант - показывать ссылку только авторизованным пользователям.

Прятать ссылку(маскировать и тд) на js, как вариант.

Спасибо за ценный материал!